Microsoft Copilot besser nutzen: Potenziale statt Frust

In unseren Workshops hören wir häufig dasselbe: Microsoft Copilot ist bereits ausgerollt, wird genutzt - und bleibt im Alltag oft hinter den Erwartungen zurück. Nicht, weil das Tool wertlos ist. Sondern weil die Stärken selten sauber ausgespielt werden.

In diesem Artikel zeigen wir, wie sich Microsoft Copilot mit einfachen Schritten spürbar besser nutzen lässt, geben unsere Einschätzung, wo Microsoft Potenzial verschenkt und warum Copilot im Enterprise trotzdem relevant bleibt.

Executive Summary

- 🧠 Copilot Agents: Custom GPTs statt echter Agenten

- ⚙️ Personalisierung: Benutzerdefinierte Anweisungen & Erinnerungen

- 🤖 Alternative Modelle: Claude in Copilot nutzen

- 🏢 Enterprise: Microsoft bleibt trotz verschenkter Chancen relevant

Wie funktionieren Copilot Agents? unterschätzt, aber falsch verstanden

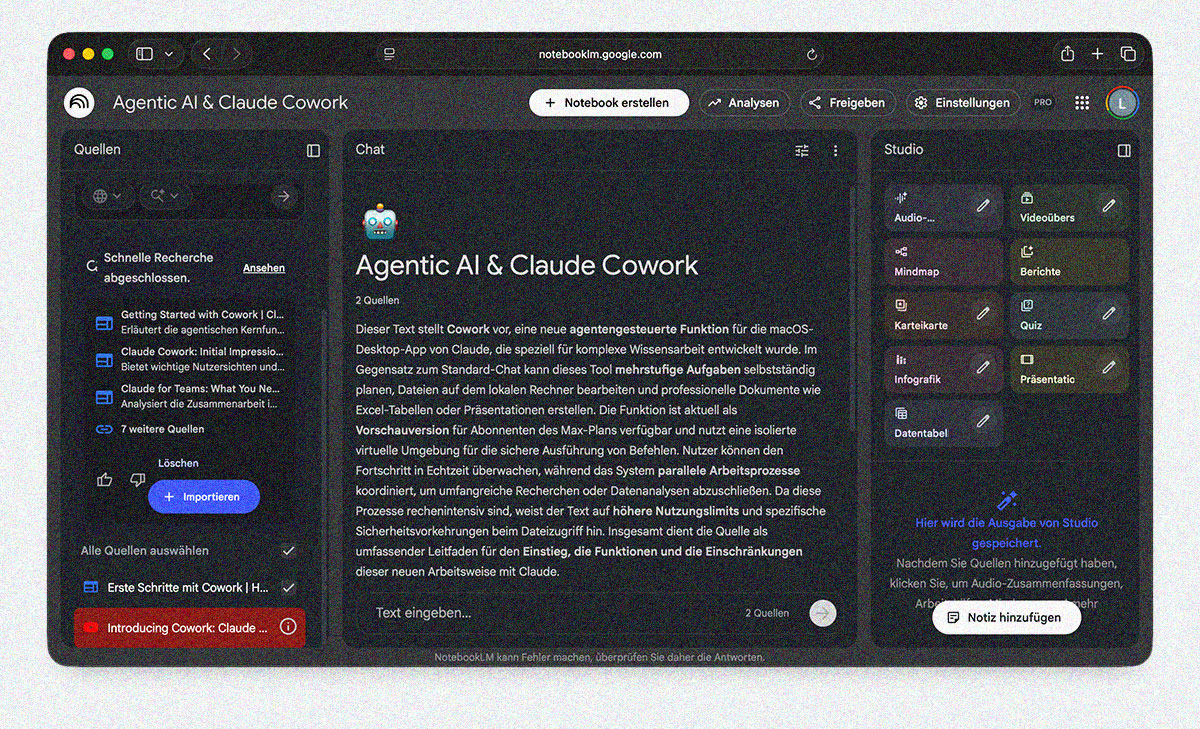

Wir haben in der Vergangenheit häufig gezeigt, welches Potenzial in Custom GPTs steckt: klarer Kontext, saubere Texte, feste Regeln. Genau nach diesem Prinzip funktionieren auch Copilot Agents. Sie bekommen einen definierten Input, greifen auf festgelegte Quellen zu und liefern einen strukturierten Output.

Wichtig ist dabei die Einordnung: Copilot Agents sind keine echten agentischen Systeme. Sie verfolgen kein Ziel, treffen keine eigenen Entscheidungen und orchestrieren keine Tasks. Im Kern sind sie Assistenten mit System-Prompt, Wissen und klaren Leitplanken.

Der große Hebel liegt im Kontext. Über angebundene SharePoint-Seiten oder Dokumente lässt sich Copilot sehr gezielt steuern. Kombiniert mit präzisen Vorgaben im System-Prompt entstehen Agents, die Texte konsistent formulieren und wiederkehrende Aufgaben deutlich besser unterstützen als der Standard-Copilot.

⚠️ Für Dokumentenzugriffe, spezifische Copilot Agents und erweiterte Funktionen sind passende Copilot-Pro- bzw. Business-Lizenzen notwendig.

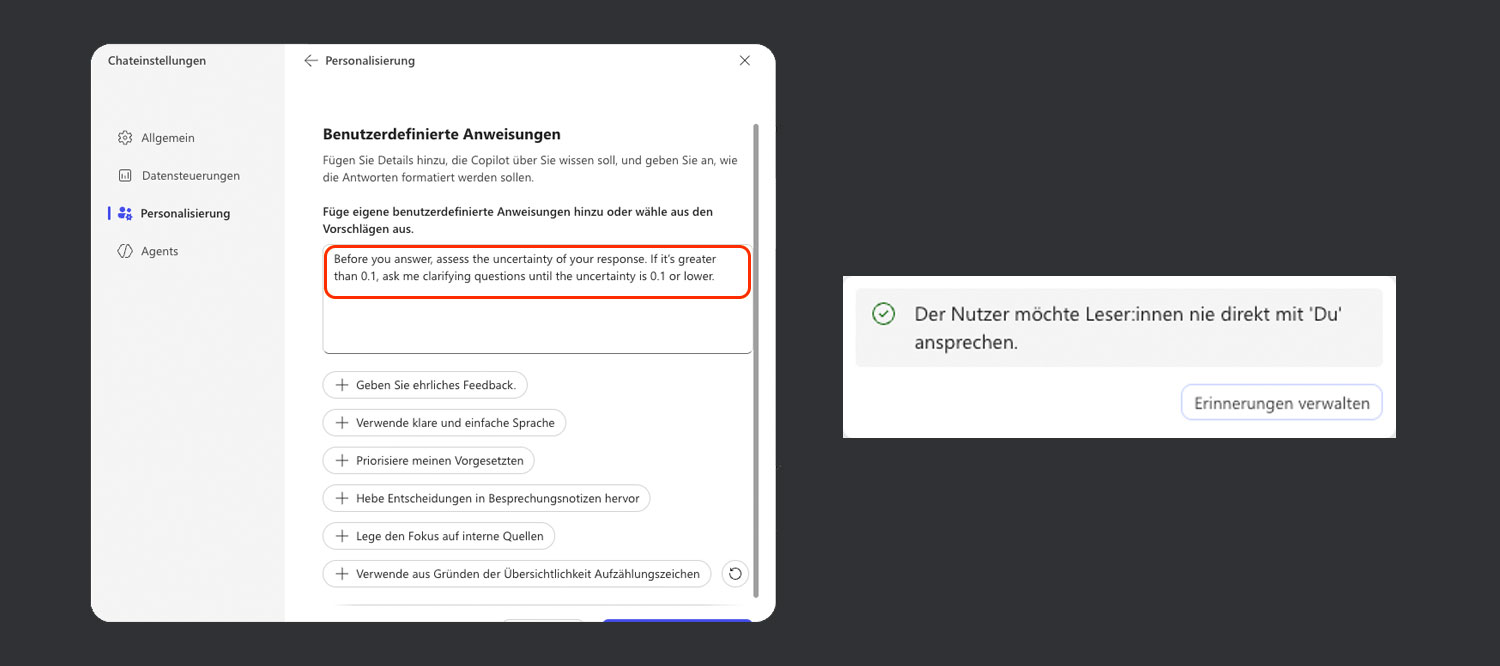

Copilot personalisieren: Ein wichtiger Hebel

Benutzerdefinierte Anweisungen in LLMs sind kein neues Konzept. Auch in Microsoft Copilot lassen sich Vorgaben dauerhaft hinterlegen - und genau das verbessert die Ergebnisse spürbar.

Der zentrale Effekt liegt in der Reduktion von Unsicherheit. Klare Anweisungen helfen Copilot, sowohl epistemische als auch aleatorische Unsicherheit zu verringern. Deshalb empfehlen wir mindestens eine zentrale Anweisung dauerhaft zu hinterlegen:

Before you answer, assess the uncertainty of your response. If it is greater than 0.1, ask clarifying questions until the uncertainty is 0.1 or lower.

Diese einfache Regel zwingt Copilot dazu, Unsicherheit offenzulegen, statt sie mit plausiblen, aber falschen Antworten zu kaschieren. In der Praxis macht das einen spürbaren Unterschied und führt zu weniger Halluzinationen, klareren Rückfragen und insgesamt stabileren Outputs.

Hinzu kommt die Memory-Funktion. Copilot kann sich formale Anforderungen merken, wenn man sie explizit einfordert. So wird das System nicht „intelligent“, aber zunehmend personalisierter.

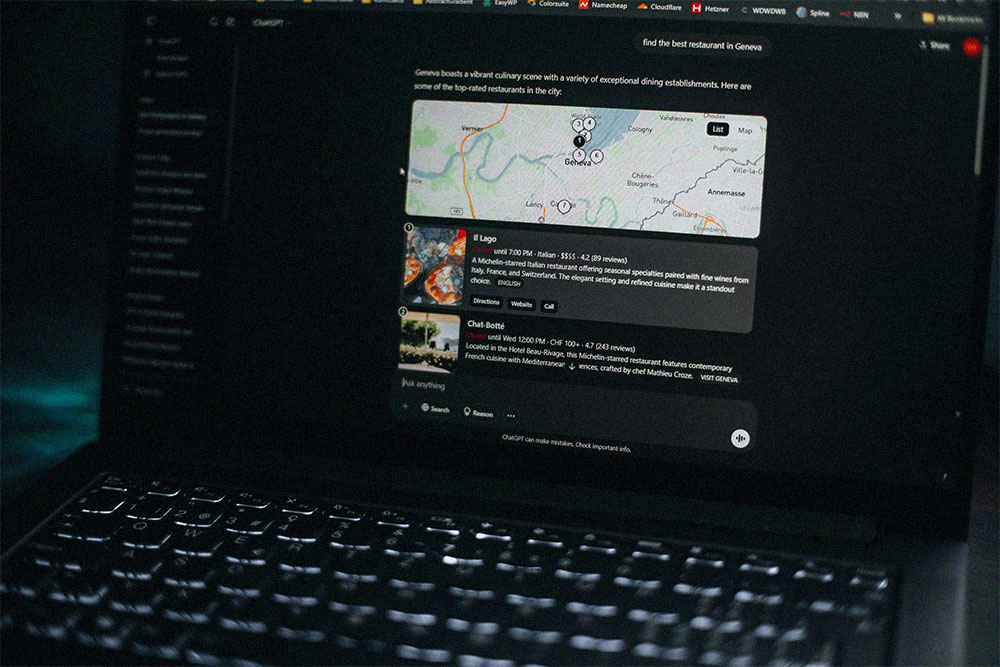

Claude in Microsoft Copilot nutzen: oft das bessere Modell

Für viele Aufgaben bietet ChatGPT nicht mehr automatisch das beste Modell. Wir arbeiten selbst häufig mit Claude - vor allem bei analytischen Fragestellungen, längeren Texten und Code-Ausgaben. In diesen Bereichen liefert Claude oft strukturiertere und präzisere Ergebnisse. Das wissen auch Microsoft-Mitarbeitende, die selbst intern vermehrt auf Claude setzen (Quelle: Reddit)

So lässt sich im Researcher-Agent auch Claude als Modell auswählen. Der Haken: Der Zugriff ist nicht standardmäßig aktiv. Ein Administrator muss zunächst im Microsoft 365 Admin Center den Zugriff auf Anthropic-Modelle freigeben.

Zugegeben: Wir gehören auch zu den enttäuschten Copilot-Nutzern. Das Potenzial der Microsoft-Infrastruktur ist riesig, die Compliance-Optionen für große Unternehmen essenziell. Und trotzdem reicht die Performance im Alltag oft nicht aus. Copilot fühlt sich häufig wie ein ChatGPT-Wrapper mit reduziertem Kontextfenster an -und dann hilft auch der theoretische Zugriff auf alle Dokumente nur begrenzt weiter.